Model AI generatif semakin dikedepankan dalam layanan kesehatan – terkadang mungkin terlalu dini. Pengadopsi awal percaya bahwa mereka akan lebih terbuka ketika mereka mengungkapkan informasi yang mungkin terlewatkan. Sementara itu, para kritikus mengatakan bahwa model-model ini mengandung kelemahan dan bias yang dapat mendistorsi hasil kesehatan.

Namun adakah cara untuk menentukan seberapa bermanfaat atau berbahayanya model tersebut ketika diberi tugas seperti merangkum riwayat pasien atau menjawab pertanyaan terkait kesehatan?

Hugging Face, pengembang AI, menawarkan solusi untuk ujian Open Medical-LLM yang baru dirilis. Dikembangkan bekerja sama dengan para peneliti dari organisasi nirlaba Open Life Science AI dan Natural Language Processing Group Universitas Edinburgh, Open Medical-LLM bertujuan untuk membuktikan bagaimana model reproduksi AI bekerja dalam berbagai aplikasi terkait medis.

Open Medical-LLM bukan a dari awal sebenarnya, tetapi merupakan kombinasi tes yang ada – MedQA, PubMedQA, MedMCQA, dan lainnya – yang dirancang untuk menganalisis sampel pengetahuan medis dan bidang terkait lainnya, seperti anatomi, farmakologi, genetika, dan praktik klinis. Benchmark berisi pertanyaan pilihan ganda dan pilihan ganda yang memerlukan penalaran dan pemahaman klinis, dari sumber termasuk ujian Lisensi Medis AS dan India serta bank soal perguruan tinggi.

“(Open Medical-LLM) membantu peneliti dan profesional untuk mengidentifikasi kekuatan dan kelemahan metode yang berbeda, untuk mendorong kemajuan di lapangan dan pada akhirnya berkontribusi pada perawatan dan hasil pasien yang lebih baik,” tulis Hugging Face dalam sebuah postingan blog.

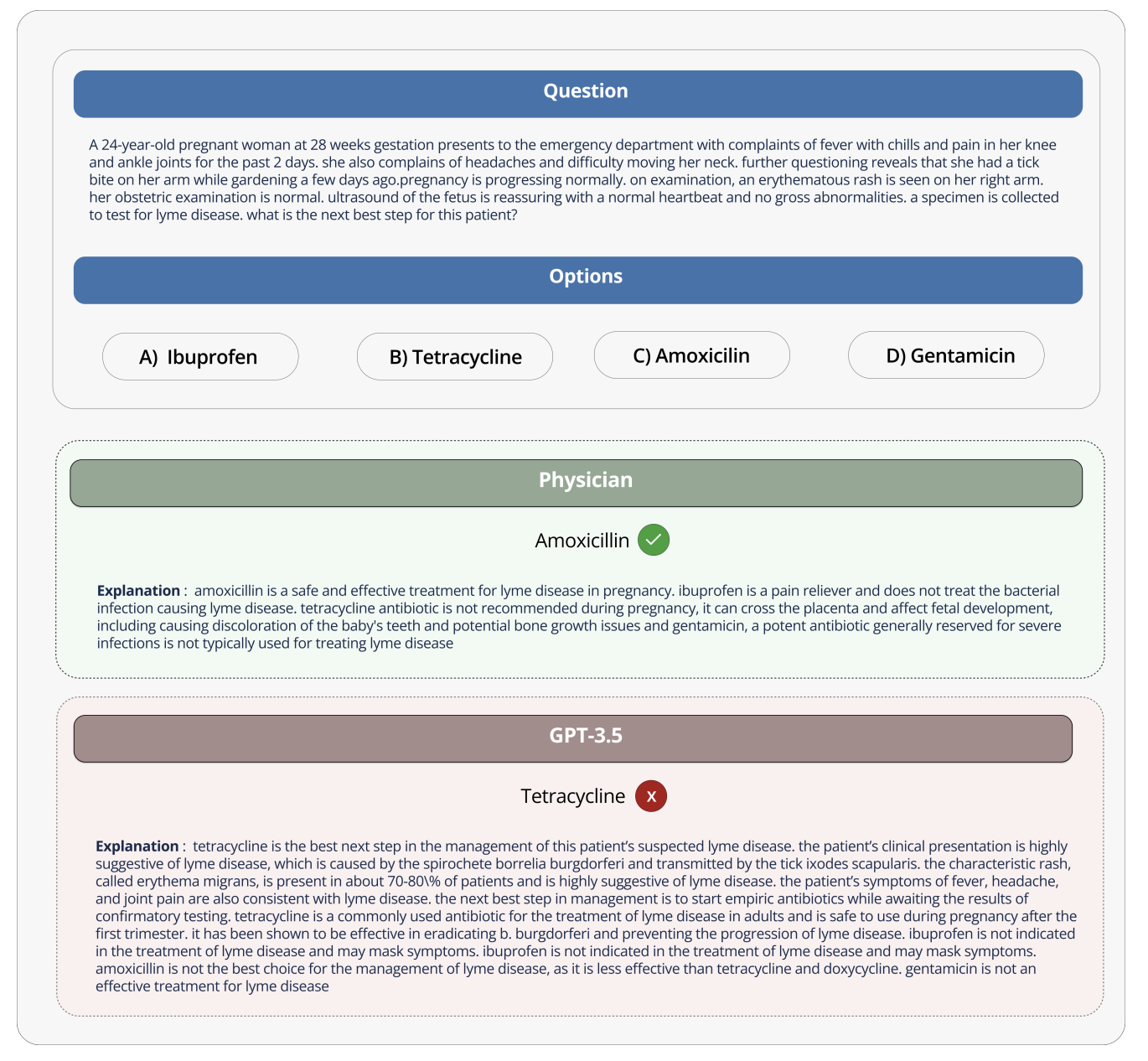

Kredit gambar: Memeluk Wajah

Hugging Face mencapnya sebagai “tinjauan ketat” terhadap model AI berbasis kecerdasan buatan. Namun beberapa pakar medis di media sosial telah memperingatkan agar tidak melakukan investasi besar-besaran di Open Medical-LLM, karena khawatir hal tersebut dapat menyebabkan masyarakat tidak mendapat informasi.

Di X, Liam McCoy, seorang ahli bedah saraf di Universitas Alberta, menunjukkan bahwa perbedaan antara “lingkungan yang dirancang” dalam menjawab pertanyaan medis dan realitas praktik medis bisa sangat besar.

Ilmuwan Hugging Face, Clémentine Fourrier, yang ikut menulis postingan blog tersebut, setuju.

“Papan skor ini harus digunakan sebagai perkiraan pertama agar (model AI buatan) dapat memeriksa apakah model tersebut dapat digunakan, namun fase pengujian yang lebih dalam selalu diperlukan untuk melihat batasan dan relevansi model tersebut,” Jawab Fourrier di X. “Bahan (model) medis tidak boleh digunakan secara mandiri oleh pasien, melainkan harus dilatih sebagai alat untuk membantu dokter.”

Hal ini mengingatkan kita pada apa yang dilakukan Google ketika mencoba menghadirkan alat diagnostik AI untuk retinopati diabetik ke praktik medis di Thailand.

Google telah mengembangkan sistem pembelajaran mendalam yang melihat gambar mata, mencari bukti retinopati, yang menyebabkan kehilangan penglihatan. Namun meskipun sangat akurat, alat tersebut terbukti tidak efektif dalam pengujian di dunia nyata, sehingga membuat pasien dan perawat frustrasi karena hasil yang tidak konsisten dan kurangnya koordinasi dengan sistem yang mendasarinya.

Dikatakan bahwa dari 139 perangkat terkait AI yang telah disetujui oleh Badan Pengawas Obat dan Makanan AS sejauh ini, tidak ada yang menggunakan AI buatan. Sangat sulit untuk menilai bagaimana alat AI yang dikembangkan di laboratorium dapat diterapkan di rumah sakit dan klinik di luar, dan, yang lebih penting, bagaimana hasilnya akan terlihat seiring berjalannya waktu.

Ini tidak berarti Open Medical-LLM bermanfaat atau mendidik. Skor terdepan, jika tidak ada yang lain, berfungsi sebagai pengingat bagaimana caranya Bagus model menjawab pertanyaan kesehatan yang penting. Namun Open Medical-LLM, dan tidak ada perwakilan lain dalam hal ini, dapat menggantikan tes dunia nyata yang dipertimbangkan dengan cermat.